Este fin de semana pasado se ha celebrado la tercera edición del Agile Open Spain que reunió unos 150 asistentes interesados en las metodologías ágiles. El desembarco de la armada de Plain Concepts fué notable, Vicenç Garcia, Ibon Landa, Gerard Lopez, Alfredo Fernandez y Jose Luis Soria (podéis ver la presentación de su sesión sobre estimación), hay es nada. Propusimos un total de cinco sesiones de los temas más variopintos… y sobre todo creo que disfrutamos un montón. Empezamos cepillandonos un chuletón para comer el viernes y acabamos con una cervecitas en el Puerto Viejo de Algorta ¿alguna manera mejor de hacer equipo?.

Si alguien duda de la calidad del evento y la diversidad de temas tratados no tiene más que echarle un vistazo al panel de sesiones. No tenéis que ver más que los twits sobre le evento.

Os dejo mis impresiones sobre las sesiones a la que acudí aunque lo más interesante en un open space pasa en los pasillos.

Test doubles: stubs, spies y mock de Rubén Bernárdez

¿Por qué usamos dobles? Para evitar dependencias externas, para que los test no sean lentos…

Interesante conversación y debate sobre los diferentes tipos de dobles de test que podemos usar, los diferentes estilos a la hora de usar test, las señales que nuestros test lanzan cuando se rompen…

Especialmente interesante para mi fue la conversación Alberto Peña en la que constaté que tenemos aproximaciones muy diferentes al testeo unitario pero que aun así los dos disfrutamos de la ventaja que tiene escribir test, los escribas antes, durante o después, los uses como herramienta de diseño o como herramienta de calidad.

Os recomiendo una artículo muy interesante que va en la línea de lo hablado en esta sesión: Exploring The Continuum Of Test Doubles.

.gif)

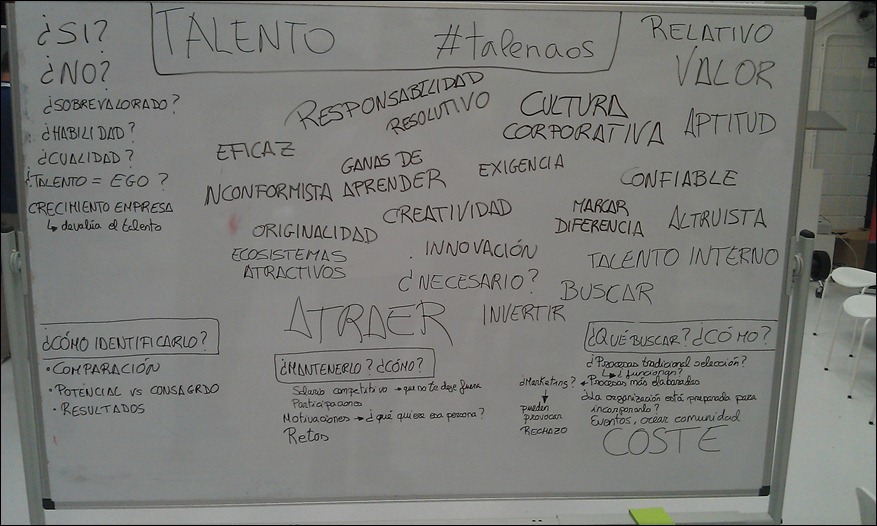

Seducir a las empresas, Raquel Laina y Amalia Hernandez

¿Nos disfrazamos para seducir a las empresas? ¿Se disfrazan las empresas? ¿Es posible no disfrazarse?… Yo defendía que todos estamos sometidos queramos o no, de manera incosciente a la tiranía de la apariencia, de la pose cuando estamos en un proceso de selección, seamos empresa o candidato. Es como ligar, propuse, nadie es la persona que se ver cuando está ligando.

¿Como presentamos el modelo alternativo que supone el agilísimo a las empresas? ¿Comó lograr que este modelo llegue a los procesos de selección? En Plain Concepts algo hacemos, por lo menos no son entrevistas convencionales, hablamos por skype, los traemos a nuestra oficina, comemos con ellos, todo el equipo está en todo el proceso…

¿Está obsoleto el modelo del currículo? Todos tenemos un currículo, es necesario diferenciarse: escribe un blog,… el papel a muerto.

Surgio una idea interesante: Desacreditar la entrevista de trabajo convencional,

Excelente resumen de Xavier Verges sobre esta sesión, en general las notas de su cuaderno sobre la AOS son una caña.

La pizarra lo dice todo…

La sesión que yo propuse: Déjame hacer las cosas bien, sobre la deuda técnica

Os dejo la presentación que utilicé, os servirá para situaros sobre los temas que debatimos.

Las notas sobre mi sesión de Frank son el complemento perfecto (también tiene notas muy interesantes sobre otras sesiones).

También en el podcast de Carlos Ble, hablo de la sesión.

Si bien Carlos Ble, uno de los habituales en estos eventos, no acudió en esta ocasión, ni aun así ha dejado de aportar. El domingo tras el evento se tomo la molestia de preparar un podcast con entrevistas a algunos de los asistentes, entre los que me encuentro. No te lo pierdas, tanto si estuviste como si no, es muy interesante. En las grabaciones podeis escuchar a Vicenç García (@vgaltes), Rubén Bernárdez (@rubenbpv), Jorge Uriarte (@jorgeuriarte), Israel Alcázar (@ialcazar), José Ramón Díaz (@joserra_biko), José Manuel Beas (@jmbeas) y yo mismo.

Un saludo.

.gif)