De una forma u otra estamos abocados a que la mayor parte de nuestra infraestructura y servicios terminen en la nube. Bajo mi punto de vista, esto es algo indiscutible, no porque nos guste más o menos, si no porque los costes decidirán finalmente que es más barato utilizar estos servicios que una estructura propia. Sin embargo, existen algunos factores que desconocemos para evaluar correctamente los costes de los servicios en la nube y éste es uno de los mayores problemas, de hecho, existe por así decirlo, cierta falta de transparencia, si oyes hablar a un comercial de venta de servicios en la nube, todo se convierte en ahorro de costes pero esto no es del todo verdad, en algunos casos es incluso al contrario.

Hace unos días estuve estudiando el coste de trasladar alguno de estos servicios a la Microsoft Azure, en concreto el relativo a SharePoint Online y Office 365, lo primero que llama la atención es la publicidad que se visualiza en la página.

Cualquiera que lea esto sin tener conocimientos suficientes podría llegar a pensar que una pequeña infraestructura sobre SharePoint para 10 usuarios podría costar 3,8 * 10 * 12 = 456 € al año y esto es completamente falso, no debemos olvidar que además del coste de los servicios de los que hablaremos más adelante, existen muchos otros que debemos seguir pagando, algunos como la administración que lejos de desaparecer se hace más importante, debemos entender que implantar un servicio como el expuesto en la imagen, va a requerir de unos servicios de configuración, administración, modelado, implantación, etc, que lógicamente no están incluidos en este precio, también hay que contar que necesitaremos seguir utilizando los equipos de clientes para acceder a la estos servicios, así que habrá que seguir manteniendo nuestro parque de pc´s, tablets, redes e infraestructura y algún que otro servidor para poder acceder y trabajar con estos.

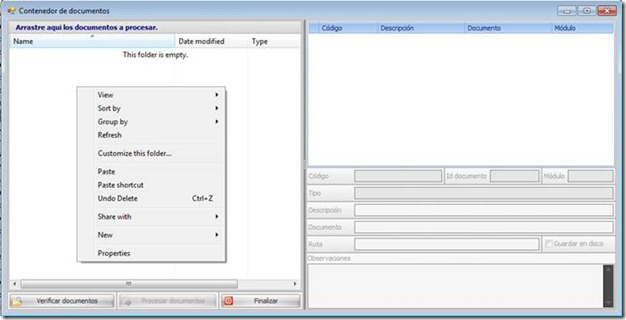

Algunos costes se incrementaran, como los relacionados con el acceso a internet, en el que habitualmente tendremos que mejorar los caudales de subida y bajada para obtener mejores tiempos de respuesta, incluso integrar comunicaciones síncronas y esto no es barato. Hay que tener en cuenta que la velocidad en el trabajo normalmente será más lenta si lo comparamos con una red local, en el manejo de archivos pequeños no notaremos grandes diferencias, pero el trabajo con archivos grandes llevara más tiempo para abrirlos y modificarlos y estos tiempos tienen un coste en el trabajo diario de cada persona que habría que estimar, algunas veces este coste hará que el uso de alguno de estos servicios sea temporalmente inviable, algo que las mejoras de velocidad y tecnología permitirán con el tiempo, recordemos que el video bajo demanda de alta calidad empieza a ser una realidad y no hace mucho tiempo era impensable. Como pequeño ejemplo en nuestra empresa tenemos archivos de diseño 3d que superan los 200 megas, cada vez que quieres manejar uno de estos ficheros y dependiendo del caudal que tengas entre la empresa y el proveedor del servicio pueden pasar varios minutos solo en abrirlo y otros tantos cada vez que actualicemos su información, en estos casos quizás sea más adecuado no subir este tipo de archivos a la nube, pero entonces tendremos otro problema añadido, deberemos tener otro sistema que nos apoye en la gestión documental y ese es otro coste que debemos asumir.

Es necesario también tener en cuenta, como con cualquier otro software que habrá que destinar partidas para formación tanto en la parte de administración como la de usuarios para poder sacar partido a estos servicios, en el caso de SharePoint estos serán de vital importancia, pues podemos encontrarnos con muchos problemas, desde usuarios capaces de subir grandes ficheros que luego no podremos utilizar hasta que el sistema se bloquee porque hemos agotado la cuota de disco o el caudal de internet, así que aspectos como la formación, configuración, alertas, mantenimiento serán de vital importancia, algunos incluso más que si nuestra infraestructura fuera interna.

Existen algunas preguntas que tenemos que tratar de responder, como las relativas a los limites del caudal de nuestra conexión con internet y con mi proveedor, en este caso Microsoft, ¿Qué velocidad tengo cuando utilizo estos servicios?, ¿Cuál es el tamaño máximo de los archivos que puedo subir?, ¿Cómo he de trabajar con archivos grandes?, Si necesito sincronizar muchos archivos con OneDrive, ¿Qué problemas de rendimiento voy a tener?, etc., muchas de ellas se contestan en la información del producto pero otras no, mi consejo aquí, además mejorar la formación, estudiar y leer todo lo posible es empezar con un proyecto pequeño y realizar pruebas reales, para ello Microsoft ofrece acceso a Azure de forma gratuita durante un mes y creo que es de vital importancia realizar varios test antes de realizar cualquier despliegue.

Una de las cosas que no me gustan mucho es esa falta de transparencia en algunos aspectos, por ejemplo en SharePoint Plan 1 te ofrecen 10 Gigabytes de tamaño base para una instalación normal y luego 500 megas por cada usuario, pero que pasa si este tamaño se sobrepasa y esto hay que tenerlo muy en cuenta, en este caso una instalación para 10 usuarios tendría una cuota de 15 Gigas, ya de entrada me choca bastante por lo poco que parece, sobre todo tratándose de un gestor documental.

Pues para resolver algunas de estas dudas llame a Microsoft, después de preguntar a varias personas me pasaron con los servicios facturación de Office 365 en donde me aclararon algunas de ellas, ante la pregunta de que sucede cuando se sobrepasa el limite de espacio contratado me dijeron que a partir de la base de 10 gigabytes mas 500 megas por usuario, el coste por gigabyte adicional es de 0.15 € por giga/ mes y aunque parezca poco, estimamos una instalación no muy grande digamos de un Tera de información correspondientes 1024 gigabytes, algo supongo que bastante habitual en un sistema de gestión documental, si ampliamos nuestra capacidad a un Tera nuestro coste aumenta considerablemente.

10 Usuarios * 3,80 € Usuario/Mes * 12 meses = 456 €

Con la licencia inicial para 10 usuarios tendría una capacidad limitada a 15 gigas correspondientes a 10 Gigas de la base + 500 por usuario y mes, es decir que me faltarían 1009 gigas que tendría que pagar adicionalmente y que supondrían:

1009 * 0.15 € * 12 = 1816,2 € al año por Tera, aquí ya la cosa cambia, y si utilizamos 2 Teras pues el doble, vamos que si tienes 100 usuarios y empiezas a subir información la sorpresa puede ser grande.

A mí me parece que este factor debería estar anunciado en la página principal y subrayado en rojo, ya he comenzado a oír algunas historias de sorpresas en algunas facturas sobre servicios en la nube.

Otra cosa que encontré leyendo sobre las características de los servicios en SharePoint Online y que me sorprendió un poco es que en la versión Plan 1 como la llaman no está incluida la versión OneDrive for Bussiness, se supone que es la herramienta adecuada para sincronizar archivos grandes con SharePoint entre otras cosas y esta se cobra aparte en este plan y cuesta otros 3,80 por usuario/mes, es decir que habría que sumar otros 456 € o contratar otro plan diferente que lo incluya.

10 Usuarios * 3,80 € Usuario/Mes * 12 meses = 456 €

En resumen que nuestro coste final se ha convertido en 456 € de licencias de SharePoint Online mas 1816 € por utilizar un Tera más otros 456 € de las licencias de OneDrive for Bussiness, ya estamos en 2724 €, a esto habría que sumarle los gastos por la infraestructura que no desaparece, como pc, tablets, infraestructura de red, así como todo lo derivado de la consultoría, administración, formación, implantación, etc.

Otros temas a tener en cuenta y que son muy importantes son las limitaciones en el tamaño de archivos, en este caso 250 megas, la limitación de subir archivos ciertos archivos, por ejemplo los que tienen extensión .exe, el número máximo de archivos por biblioteca, etc.

Debemos tener en cuenta también que el coste de estos servicios es por uso, es decir que si el primer mes solo utilizamos 100 Gigas solo pagaremos por estos y este se irán incrementando o decrementando dependiendo del uso que le demos, así que los cálculos anteriores no son del todo reales. Pero ya nos podemos ir dando cuenta de la importancia de utilizar planes de mantenimiento, reglas, alertas, etc., para evitar pagar más de lo necesario, la administración de los sistemas en la nube al contrario de lo que pueda parecer, será de vital importancia para ahorrarnos costes. También es importante saber, que una de las ventajas que obtendremos es la versatilidad, podemos eliminar y añadir licencias en cualquier momento y esto es una gran ventaja, pues la filosofía sigue siendo paga por aquello que utilices, así pues si tenemos una punta de trabajo y necesitamos adquirir algunas licencias mas, lo haremos facilmente a golpe de ratón, lo mismo para eliminarlas.

Otro factor a tener en cuenta son los plantes de pago, Microsoft cobra un precio si contratamos el servicio de forma mensual y otras más barata de forma anual, si bien en ambos permite facturación mensual, esto es así porque los precios están en constante evolución y varían muy rápido, si contratas el plan anual el precio es menor, pero no sufre variaciones a lo largo de los doce meses y si lo haces de forma mensual el precio es más caro, pero puede sufrir variaciones, como ejemplo no hace muchos los precios por giga de almacenamiento en SharePoint costaban muchísimo más, creo que más de un euro en lugar de los 0,15 céntimos que cuestan ahora.

Esta es una de las claves de los servicios en el futuro, estos costes van a continuar bajando considerablemente, sobre todo debido a la competencia en grandes empresas Microsoft, Amazon, Google, Oracle, Apple, DropBox y otros que están librando esta batalla en un negocio que se convertirá en el pilar fundamental de sus empresas durante muchos años, de hecho, creo que este fue uno de los principales motivos de la elección del actual presidente de Microsoft ya que él era el encargado del grupo de desarrollo de servicios para la nube.

Esta lucha continua por ganar usuarios y las mejoras tecnológicas constantes bajaran los precios durante los próximos años y harán que tarde o temprano la mayor parte de las empresas suban la mayor parte de sus infraestructuras a la nube, si bien estas no desaparecerán del todo y durante los próximos años la mayor parte de las soluciones serán híbridas.

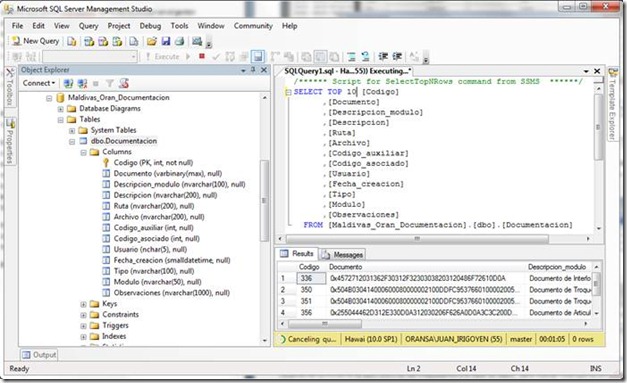

Si hablamos de servicios como Sql Server en Azure la complejidad todavía es mayor, ya que te cobran por conceptos como transacciones, ancho de banda, redundancia, cache, etc.

Una herramienta útil para calcular los costes esta publicada desde hace algún tiempo es http://azure.microsoft.com/en-us/pricing/calculator/ y facilita bastante el proceso, existen también calculadoras de proveedores de servicios externos. Sin embargos todavía hay algunos servicios que no están suficientemente claros y debemos leer toda la letra pequeña si no queremos llevarnos sorpresas en la factura.

A modo de resumen, adjunto un pequeño informe que utilice para poder tener una idea aproximada de algunos servicios en la nube, seguro que puede existir otras combinaciones y quizás pudiera faltar o sobrar alguna cosa, pero os servirá para daros una idea, los precios no llevan incluido el IVA.

– Versión SharePoint Online Plan 1 (Incluye solo SharePoint, OneDrive tiene cargo adicional)

No incluye licencias de Office online ni Office versión escritorio ni OneDrive para manejar archivos grandes que tiene un coste adicional por Usuario/Mes.

Se podría eliminar el servidor de SharePoint y su mantenimiento

Las diferencias entre Sharepoint Plan 1 y Plan 2 son en funcionalidad, el plan dos tiene enlaces con base de datos, búsquedas avanzadas, etc

10 usuarios con 15 Gb de capacidad en SharePoint: 480 € al año

20 usuarios y 425 Gb de capacidad en SharePoint: 960 € + (10 usuarios * 3,80 Usuario/mes de OneDrive) + 720 € almacenamiento adicional 400 Gb = 2136 € al año

– Versión Office 365 Enterprise E1 (Incluye servidor de Correo, SharePoint, Yammer, OneDrive, Office Online)

Incluye las licencias de Office Online pero no incluye licencias de Office versión escritorio.

Se podría eliminar el servidor de Exchange, SharePoint y su mantenimiento. No incluye las versiones de Office 2013 en equipos Windows.

10 usuarios: 732 € al año con 15 Gb de capacidad en SharePoint

20 usuarios y 425 Gb de capacidad en SharePoint: 1464 € + 720 € almacenamiento adicional 400 Gb = 2184 € al año.

Una buena oferta en relación calidad/precio, pues incluye One Drive y Office Online y los servicios de correo.

– Versión Office 365 Enterprise E4 (Incluye servidor de Correo, SharePoint, Yammer y licencias de Office Online y versión de escritorio para equipos). La más completa

Se podría eliminar el servidor de Exchange, SharePoint y su mantenimiento.

Incluye todas las versiones de Office Online y Office versión escritorio.

10 usuarios con 15 Gb de capacidad en SharePoint: 2400 € año

20 usuarios y 425 Gb de capacidad en SharePoint: 4800 € + 720 € almacenamiento adicional = 5520 € al año.

Recordar que los precios y planes están en constante evolución y en poco tiempo estos ejemplos pueden no servir de nada.

Es una pena que el la idea del pago por uso no sea real, pues continúan

obligando al pago de una licencia de software por usuario, sin embargo sería más

adecuado pagar solo cuando se utiliza el servicio, pueden existir usuarios que

no utilicen el sistema más que unas horas al año y otros que lo hagan de forma extensiva,

de forma similar, muchos usuarios de Office 365, solo utilizaran Word y Excel y

solo algunos pocos utilizaran las otras herramientas, así que el pago de la

licencia sigue siendo desigual, sin embargo el pago por almacenamiento me parece mas adecuado pues pagas solamente por lo que estas usando.

Los servicios en la nube son una oportunidad de negocio para muchas empresas y están aquí para quedarse, pero debernos estudiarlos a fondo antes de realizar cualquier implantación, recordar que en el caso de Microsoft se proporcionan versiones de prueba gratuitas http://azure.microsoft.com/en-us/pricing/free-trial/ y podemos evaluar mejor el coste real de estos servicios, otra posibilidad es utilizar el crédito mensual gratuito que nos ofrece la licencia de MSDN para desarrolladores.