Yesterday the new DotNetNuke 6.2 Beta 2 was released on CodePlex with a bunch of new features and fixes that allows new possibilities like creating your own and private social network, plus other mobile capabilities like mobile website redirection on CE version. The new 6.2 release continues with the new CMS paradigm that was announced at the DNN World 2011 Conference: CMS = “Cloud” + “Mobile” + “Social”.

Yesterday the new DotNetNuke 6.2 Beta 2 was released on CodePlex with a bunch of new features and fixes that allows new possibilities like creating your own and private social network, plus other mobile capabilities like mobile website redirection on CE version. The new 6.2 release continues with the new CMS paradigm that was announced at the DNN World 2011 Conference: CMS = “Cloud” + “Mobile” + “Social”.

I’m pleased to announce that a new Beta release of the DotNetNuke Azure Accelerator has been released and is also available on CodePlex, that includes both fixes and new great features that I’ll try to summarize in this post.

Download DotNetNuke Azure Accelerator 6.2 Beta

New DNN Azure Accelerator 6.2 Beta

What you can expect from this release is a new version of the Accelerator wizard and packages, that are capable to use your actual VHDs and SQL Azure databases but adding new features on the Azure hosting environment and fixing some behaviors. If actually the Accelerator will install the 6.2 Beta 2 version on empty VHD drives, this will be only during this Beta phase –that will end with the final DotNetNuke 6.2 release- and probably the “6.2” will be removed from the name of the Accelerator using other nomenclature, because a new agnostic feature allows to deploy the latest available DNN CE version on CodePlex, no matter which version. So expect also a “name” change on the Azure Accelerator before the final release.

The categorized list of new features is as follows:

1. Changes on the Wizard

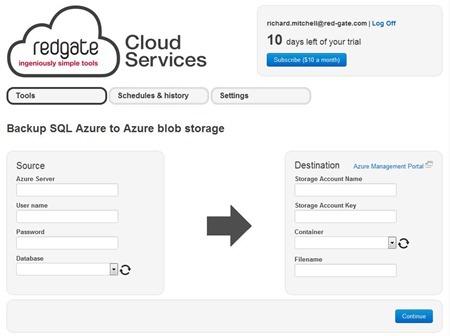

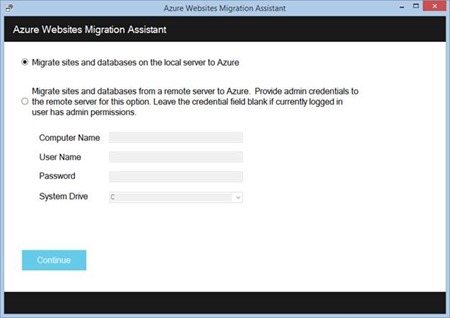

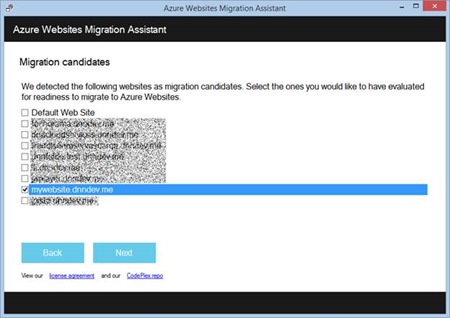

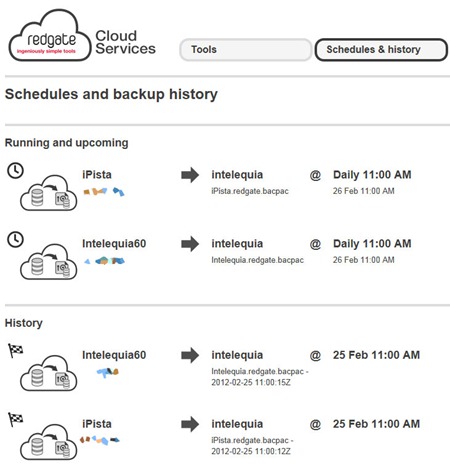

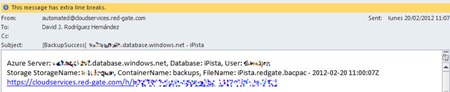

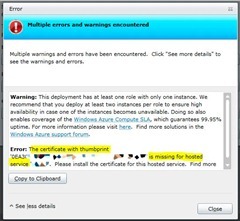

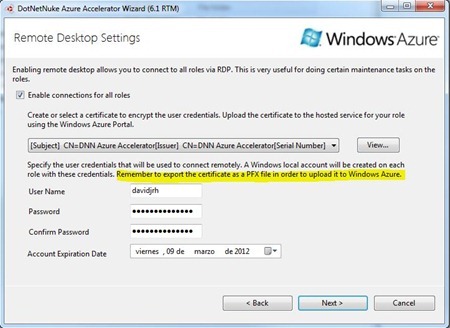

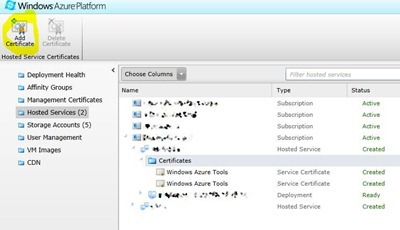

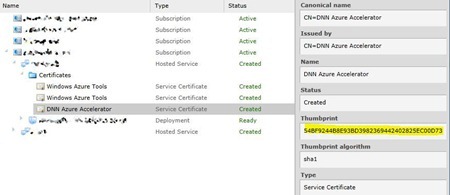

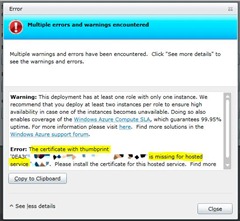

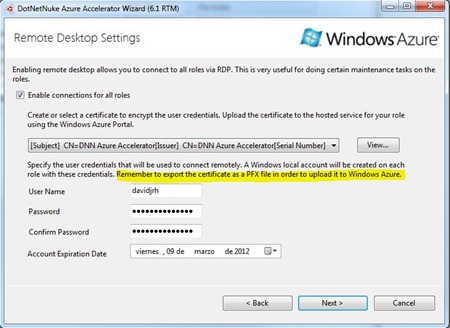

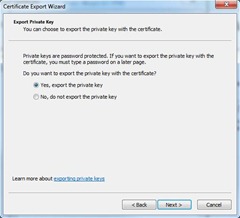

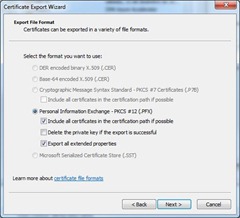

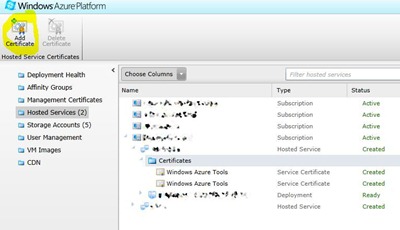

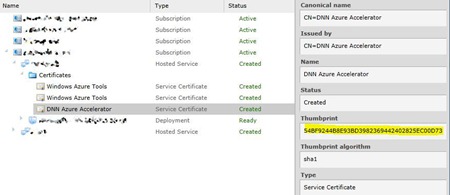

- Automatic provisioning and deployment: this is probably one of the new features that new users will like a lot, because using the same technique that uses the Azure SDK 1.6 for Visual Studio, allows to automatically download a publish settings file and manage remotely your subscriptions. After getting this publish settings, you can select the hosted service, storage account and SQL Azure database, all from the wizard. If you don’t have provisioned them from the Windows Azure Portal, you can do it from the wizard. This includes the automatic creation of the proper SQL Azure firewall rules. Before deploying, the status of the provisioned resources is verified in order to check that all of them are available (i.e. verify and wait for storage account ready status). If the target slot is occupied by a previous deployment, a confirm dialog appears for overwriting the current deployment –only the VM, not the VHD or database. The PFX certificate is also automatically uploaded and configured on your hosted service without any user interaction.

- Option for automatic installation: a new option located in the package selection step, allows to select auto-installation as the final step of the deployment, using the DotNetNuke default parameters. If you select this you will have a fully functional site running on Windows Azure deployed with the default website template and default credentials (user “host”, password “dnnhost”). Remember to change this credentials as soon as possible.

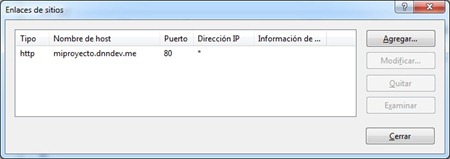

- Deploying on Azure staging environment: as the new package does not need “host headers” for the site –see package new features below- now you can deploy on Staging environment –and you can start playing with the Swap VIP button on the Windows Azure Management Console.

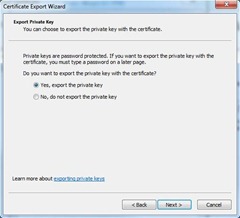

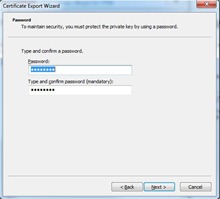

- Option to export the wizard results to local file system: there is an option -that not uses Azure managed services- to create and configure a service configuration file and service package, exporting them to a folder for manual deployment, useful on some scenarios. The PFX file is also exported –you will be asked for a password- for manual import.

2. Changes on the packages

- Automatic DNN CE download from CodePlex: another important feature on the Accelerator is the automatic download of the latest available DNN CE package from CodePlex on first Azure role run –when the package is deployed on Azure and the VHD drive is empty. You can overwrite the «packageUrl» setting to download from any other customized location, like previous Azure Storage container locations or any other. BETA: this Url actually points to the DNN CE 6.2 Beta 2 version until final 6.2 release. The download is done directly from CodePlex to your hosted service on Azure.

- Changed default binding: The default website will be the DotNetNuke website instead of the webrole website, what means that specifying host headers is no longer mandatory, and enables the possibility of deploying on Staging environment and other operations like Swap VIP

- Database creation on role startup: now on role startup, the database and login user will be created if the database does not exist. This will make easier to create new DNN service deployments by simply changing the service configuration file without having to do that task manually or through the accelerator wizard.

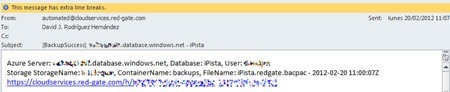

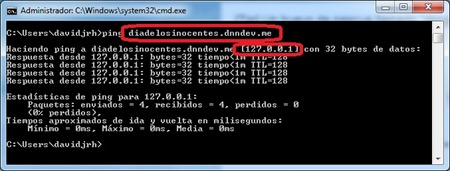

- New deployment progress page: added new deployment progress page on the webrole website, showing the service deployment status until the site is ready. By default, the deployment log stored on Table Storage is not shown on this page, but you can enable it on the service configuration file for debugging purposes. You can access also these details using remote desktop on any webrole and browsing «http://admin.dnndev.me».

- Smaller download: the packages has been moved to a separated download –not available yet on Beta phase. The wizard comes with the «Azure Single and Small» package so the DNNAzureAccelerator package only weights 4Mb.

3. Fixes and enhancements

- Modified the local file sharing user account creation on roles to don’t allow account expiration after a month (needs revision, the approach must be different)

- Modified the web roles endpoints to allow traffic on port 443

- Changed the package unzip operations to use managed code (ICSharpCode.SharpZipLib.dll)

- Use of «netsh advfirewall firewall» to allow traffic on the SMB server (see http://support.microsoft.com/kb/947709/)

- Use of Windows 2008 R2 OS

- Automatic adition of «IsWebFarm» app setting in the web.config file to enable the FileCachingProvider

- Changed the Azure diagnostic monitor initialization. Now the events are being correctly logged on web roles.

Pending planned tasks

The pending tasks planned for the final release are:

- Add HA support for the SMB worker role, actually doing tests on the solution taken

- Handle the “Changing” event to detect configuration or topology changes and act in consequence

- Change the long process tasks on the wizard as background workers to not freeze the UI

Please, if you detect any bug on this release, create an issue on the Issue Tracker page available on CodePlex.

Enjoy it!